Appleは2021年8月に、iOSデバイス上やiCloudに保存された画像をスキャンして「児童の性的搾取に関連するデータ(CSAM)」をハッシュからチェックする仕組みを、2021年後半にリリースされる予定のiOS 15に組み込むと発表しています。このハッシュ照合アルゴリズム「NeuralHash」には異なる画像から同じハッシュが検出される「ハッシュ衝突」の欠陥があるという指摘がセキュリティ研究者から上がっています。

GitHub - AsuharietYgvar/AppleNeuralHash2ONNX: Convert Apple NeuralHash model for CSAM Detection to ONNX.

https://github.com/AsuharietYgvar/AppleNeuralHash2ONNX

Apple says collision in child-abuse hashing system is not a concern - The Verge

https://www.theverge.com/2021/8/18/22630439/apple-csam-neuralhash-collision-vulnerability-flaw-cryptography

Apple didn't engage with the infosec world on CSAM scanning – so get used to a slow drip feed of revelations • The Register

https://www.theregister.com/2021/08/18/apples_csam_hashing/

2021年8月5日、Appleは「子どものための拡張された保護」と題するページを公開し、CSAMの拡散を制限するために、新たな安全機能を導入すると発表しました。この安全機能は、機械学習アルゴリズムであるNeuralHashによって写真のハッシュ値をデータベースと照合することでCSAMを検出し、公的機関に報告するというものです。

AppleがiPhoneの写真やメッセージをスキャンして児童の性的搾取を防ぐと発表、電子フロンティア財団などから「ユーザーのセキュリティとプライバシーを損なう」という抗議の声も - GIGAZINE

しかし、クラウドだけではなくデバイスにあるデータも勝手にチェックするAppleのCSAM検出はプライバシーの侵害であるとして、強く批判されています。

Appleの「iPhoneの写真やメッセージをスキャンする施策」が世界各国の監視&検閲の強化につながるとの指摘 - GIGAZINE

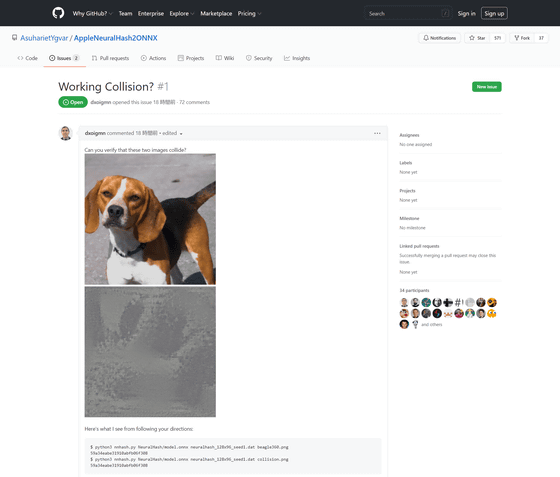

2021年8月17日にGitHubユーザーのAsuhariet Ygvar氏が、リバースエンジニアリングでiOSから抽出したCSAM検出用のNeuralHash APIをPythonのオープンソース機械学習フレームワークであるOpen Neural Network Exchangeに変換するスクリプト「AppleNeuralHash2ONNX」をGitHubに公開しました。なお、CSAM検出に使われるNeuralHashは最新バージョンではなく、2020年12月14日にリリースのiOS14.1に実装された少し古いバージョンだとのこと。

そして、2021年8月18日に、Intelの研究機関であるIntel Labsの研究者であるコリー・コルネリウス氏は、犬の写真と灰色の画像という全く異なる画像でハッシュ衝突が確認できたと報告しています。

Working Collision? · Issue #1 · AsuharietYgvar/AppleNeuralHash2ONNX · GitHub

https://github.com/AsuharietYgvar/AppleNeuralHash2ONNX/issues/1

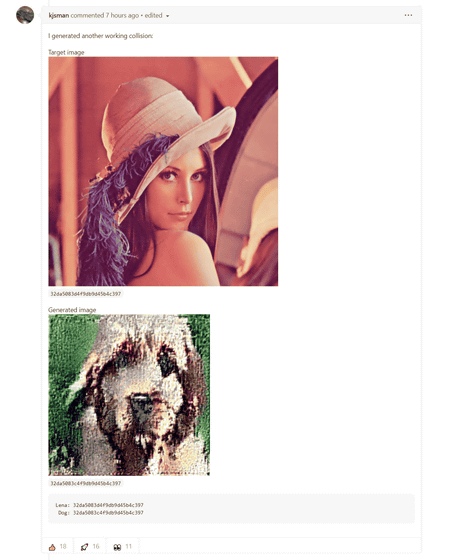

さらにGitHubのフォーラムでは、他にもハッシュ衝突が確認できる例が発見されています。

Appleはハッシュ衝突の可能性を否定していませんが、「ハッシュ衝突が起こる確率は1兆分の1」と述べ、取り立てて問題とするレベルではないとしています。しかし、ジョンズ・ホプキンス大学の計算科学者であるマシュー・グリーン氏は「はっきり言って、Appleは『ハッシュ関数における偶発的な偽陽性は非常に低い』と主張しているだけで、意図的に作られた偽陽性については何も述べていません」と批判しています。

グリーン氏は「NeuralHashではこのようなハッシュ衝突が起こることは以前から明白でした」と述べ、Appleがリスクを隠すためにNeuralHashのソースを公開していないと主張。また、一見無害でも児童性的虐待画像として認識されてしまう画像を悪用するという手口も十分想定できると指摘しました。

It was always fairly obvious that in a perceptual hash function like Apple’s, there were going to be “collisions” — very different images that produced the same hash. This raised the possibility of “poisoned” images that looked harmless, but triggered as child sexual abuse media.

— Matthew Green (@matthew_d_green) August 18, 2021