2021年8月5日、Appleは「Child Sexual Abuse Material(CSAM:児童の性的搾取に関連するデータ)」の拡散を防止するための取り組みとして、アメリカのApple端末ユーザーのメッセージや写真をスキャンし、CSAM関連コンテンツが存在しないかをチェックすると発表しました。この取り組みについては「プライバシーの侵害だ」などの批判的な声も多数挙がっているのですが、新たにアメリカ国外での同取り組みについて、「現地の法律および規制に応じ、国ごとに行っていく」という方針をAppleが明らかにしています。

Apple says any expansion of CSAM detection outside of the US will occur on a per-country basis - 9to5Mac

https://9to5mac.com/2021/08/06/apple-says-any-expansion-of-csam-detection-outside-of-the-us-will-occur-on-a-per-country-basis/

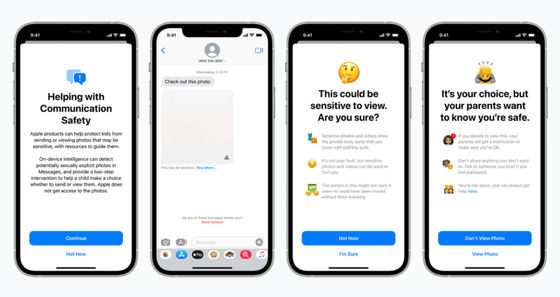

8月5日にAppleが発表したCSAM拡散防止に向けた取り組みは、主に「メッセージアプリ」「iCloud写真」「Siriと検索機能」上で、ユーザーのプライバシーを損なわない形でコンテンツを検閲したり、ユーザーがCSAMについて検索した場合に警告したり、子どもがCSAMを送信してしまった場合には親に通知したりするというものです。AppleがCSAMの拡散防止に向けて実装予定の各機能の詳細については、以下の記事にまとめられています。

AppleがiPhoneの写真やメッセージをスキャンして児童の性的搾取を防ぐと発表、電子フロンティア財団などから「ユーザーのセキュリティとプライバシーを損なう」という抗議の声も - GIGAZINE

Appleの発表したCSAM拡散防止システムに対しては、電子フロンティア財団やCenter for Democracy and Technologyといった団体から「プライバシーが損なわれる」という非難の声が挙がっていますが、Appleは子どもたちを守るためには必要なものであり、すべてプライバシーを念頭に置いて設計されていると強調しています。

AppleのCSAM拡散防止システムについては、プライバシー面の懸念だけでなく「バックドアを設置するようなものだ」という意見もあり、具体的には「政府機関が同システムを他の目的で利用しようとした場合」などを危惧する声が挙がっています。

電子フロンティア財団は、「Appleが構築しているシステムは狭いバックドアを設けるようなもので、このバックドアを広げるために必要なことは、CSAMだけでなくさらに幅広いコンテンツをスキャンするための『機械学習パラメーターの拡張』や、子どもだけでなくすべてのアカウントをスキャンするよう『構成フラグを微調整すること』です」と指摘しており、CSAM拡散防止システムを調整するだけで、ユーザーを監視できるような危険なシステムに変化しうると警告しています。

なお、Apple関連メディアの9to5MacがAppleに対して「アメリカ国外でCSAMコンテンツの検出をどのように行っていくか?」と問い合わせたところ、Appleはアメリカ国外に取り組みを拡大する時期については詳細を明かさなかったものの、それぞれの国と地域の法律および規制に応じながらシステムを拡大していくと語ったそうです。