人間が書いたものと見分けが付かないぐらいに精度の高い文章を生成できる言語モデル「GPT-2」の後継である「GPT-3」が、人工知能を研究する組織・OpenAIにより公開されました。

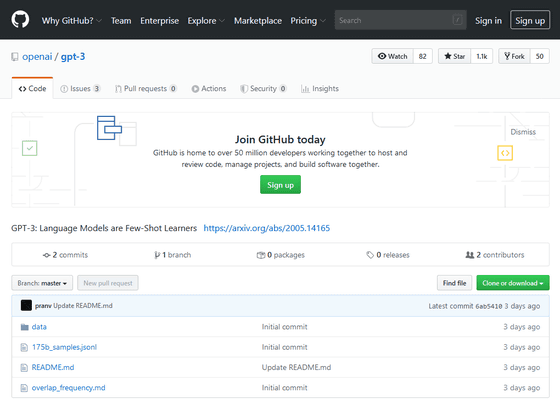

GitHub - openai/gpt-3: GPT-3: Language Models are Few-Shot Learners

https://github.com/openai/gpt-3

[2005.14165] Language Models are Few-Shot Learners

https://arxiv.org/abs/2005.14165

OpenAI debuts gigantic GPT-3 language model with 175 billion parameters

https://venturebeat.com/2020/05/29/openai-debuts-gigantic-gpt-3-language-model-with-175-billion-parameters/

2019年に公開された「GPT-2」は、その優秀さゆえに開発陣からすら「危険すぎる」と問題視され、技術的な詳細を記した論文の公開が延期された代物です。

AIによる自動文章作成ツールがあまりにも高精度のテキストを簡単に作り出してしまうため開発陣から「危険過ぎる」と問題視される - GIGAZINE

この「GPT-2」でもパラメーターは15億個でしたが、新バージョンである「GPT-3」は1750億個のパラメーターを持つとのこと。

ただし、どんな状況にでも最適な言語モデルというわけではなく、言語翻訳やニュース記事生成、大学進学適性試験の解答などの自然言語処理では最先端の結果を得られるものの、常識的な推論の部分では物足りないことがあり、単語文脈分析や中学・高校の試験問題解答においてはやや落ちる部分が出てくるそうです。

なお、論文では「GPT-3」を用いて、人間が書いたものと区別がつかないようなニュース記事が生成されたことが報告されています。